こんにちは!

今日は、報道で大きく流れている「アンソロピック(Anthropic)が“著作権訴訟”で少なくとも15億ドルの和解案に合意したらしい」というニュースを入口にして、生成AIの危険性とデメリット、そしてそれでも使いこなすメリットを、人が読みやすい形でぎゅっとまとめます。

米国時間の2025年9月5日(日本時間だと9月6日)に、ワシントン・ポスト、ロイター、APなどが一斉に報じています。和解は裁判所の承認待ちで、1作品あたりおよそ3,000ドルが目安、さらに不正入手した書籍データの破棄が含まれると伝えられています。まずはここから何が読み取れるかを整理します。

要点

今回の和解報道が示したのは、「AIの価値は大きいが、データの“入手と使い方”を間違えると法的にも事業的にも高くつく」という当たり前の教訓です。

ポイントは3つです。

①金額規模:少なくとも15億ドルで、約50万点×3,000ドルの目安と報じられています。

②中身:違法に取得した(海賊版などの)書籍データの削除・破棄が条件に含まれるとされています。

③位置づけ:裁判所の承認が前提で、合法に入手した書籍での学習は“フェアユースになり得る”が、海賊版の取得・保管はアウトという線引きが浮き彫りになりました。要は、「AI可否の二択」ではなく、“調達と運用設計”が価値とリスクを分けるという話です。

和解は9月上旬に審査される見込みという報道もあります。

今回のニュースで“確実に押さえたい”3つ

①金額と規模

15億ドルという額は、著作権関連の和解として過去最大級と報じられています。1作品3,000ドル×約50万点という換算で、総額がさらに増える可能性も示されています。ここは、他社や他分野にとっても「コストの実感」を与える部分です。

②条件の方向性

報道では、不正取得データの“破棄”が合意条件に含まれるとされています。つまり「混入した後の修復」は高コストで、“混入させない設計”が最強の守りだと分かります。

③法的整理の含意

合法入手データでの学習はフェアユースに当たり得る一方、海賊版の取得・保管は厳しく問われ得るという、“入手経路”こそが勝負という構図がはっきりしました。和解は裁判所の承認待ちである点も見逃せません。

「危険性とデメリット」—7つの現実

1)違法・不適切なデータ取得の法的リスク

性能の鍵はデータですが、入手の作法を誤ると、後からいくら“安全策”を積んでも土台が揺らぎます。今回の和解報道はまさにこの教訓で、違法入手の疑いが高額和解に直結しました。商用展開が進むほど、賠償に加えてブランド毀損や提携解消など二次被害が連鎖します。

2)“機械アンラーニング”は魔法ではない(削除の難しさ)

一度大規模モデルに混ざったデータの影響だけを消すのは難題です。再学習や蒸留で時間・コストが膨らみ、派生モデルやキャッシュまで汚染されます。だから混入させないが正解です。報道で語られるデータ破棄という条件感は、現実の運用負債の大きさを示しています。

3)透明性不足=採用の妨げ

「何で学んだの?」に社内外で答えられないと、監査対応のある業界ほど導入が止まります。出所(lineage)の記録や説明責任が不十分だと、便利さよりリスクが勝ちます。これはAI特有の“ブラックボックス感”が背景にあります。

4)規制・契約コストの膨張

和解金だけでなく、係争対応・人員再配置・監査強化・ベンダー差し替えなど、見えないコストが積み上がります。契約のインデムニティ(補償)や監査条項は重くなり、案件のリードタイムも伸びがちです。

5)出力物の権利トラブル

学習データが問題でなくても、アウトプットが“実質的に酷似している”と主張されるケースや、歌詞・漫画など保護が強い領域は火傷しやすいです。公開前の人手チェックがコスパ最強の安全策になります。

6)“グレー運用の拡大”という組織の罠

「みんなやっている」「判例が固まっていない」という空気で運用を広げると、急に赤信号になった時に全部止まります。まずは低リスク領域から始めて、ルールと人材の経験値を貯めるほうが結局速いです。

7)人間の判断力の“筋力低下”

AIに寄りかかるほど、裏取りや一次情報へのアクセスをサボりがちです。今回のようなニュースで“事実→解釈→自社運用”を整える筋力を、意識して残すことが必要です。AIは補助輪です。いずれ外せると便利さはさらに増します。

「それでも使うメリット」—7つの武器

1)時間の爆縮

骨子づくり、議事要約、FAQ、コード雛形、エクセル関数の案出し。0→0.6を一瞬で出せます。人は0.6→1.0の磨きに集中できます。

2)発想の多様化

AIは偏りをリセットして、別視点を機械的に出します。30本のキャッチや逆説的な課題定義など、人手では重い探索を肩代わりします。

3)“参照型”(RAG)で安全×効果

学習より参照中心にすると、外部データの恒久取り込みを避けつつ、最新情報を反映できます。由来が明確な自社データ+検索連携で、まず成果を出すのが現実的です。

4)ナレッジの民主化

属人化した社内情報を自然言語で引き出せるので、新人や他部門でも“わかる・できる”が早くなります。

5)小さな組織こそ恩恵大

中小・個人では外注費削減とスピードの両取りが可能です。スモールスタートでも効果を体感できます。

6)品質の底上げ

言い回しの改善、誤字検知、論点の漏れチェックが習慣化します。最終品質のムラが減るのが地味に効きます。

7)学習コストの平準化

新ツール導入のたびの勉強コストを、対話で吸収できます。“聞けば返る”が定着すると、現場の心理的ハードルが下がります。

“どう使うか”の設計図(現実解)

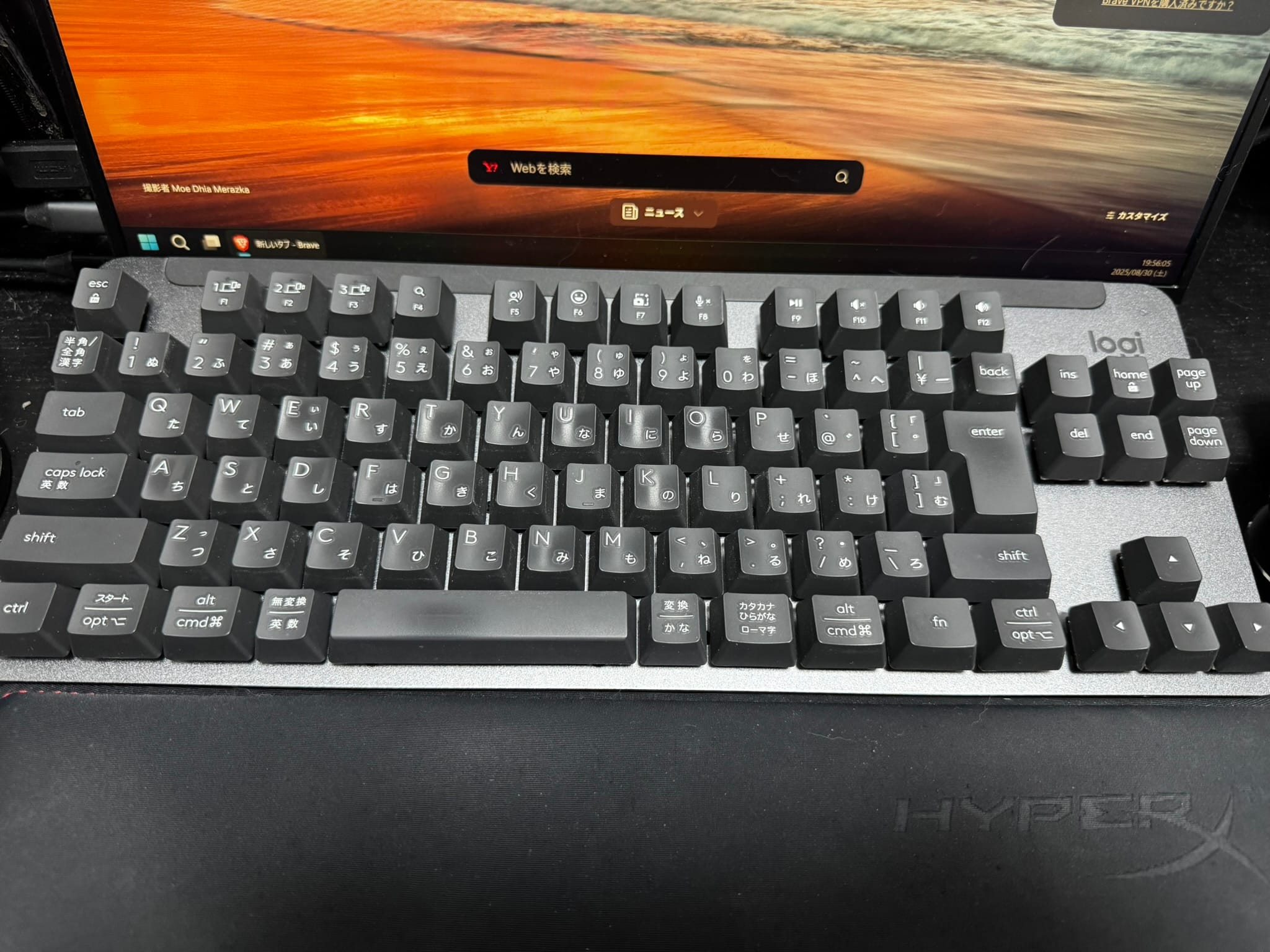

まず方針を“参照優先(RAG)”に置きます。モデル再学習や外部データの恒久取り込みは後回しにします。次に、データ来歴(ライセンス)台帳を作って、取得元・契約・停止義務を記録します。社外公開に回る生成物は、著作権・商標・肖像の観点で人手レビューを必須にします。さらに、プロンプト・出力・利用先をログ化して、差し替えや遡及対応に備えます。

今回の報道でも示されたように、“違法取得の破棄”という話が出るレベルになると、やり直しは高コストです。だったら混入前のコントロールで止めるほうが圧倒的に安いです。

よくあるアドバイスへの小さな異議

「とにかく触れ、やりながら覚えろ」は勢いがありますが、ファインチューニングや外部データの継続取り込みを安易に始めると、権利クリアの目利きが追いつかないまま取り返しのつかない状態になります。最初は“学習”より“参照”、“開発”より“運用設計”を優先します。

スピードは出したいけれど、止まらないスピードのほうが価値があります。ちょっと厳しめに聞こえたらごめんなさいですが、ここは後戻りコストを見て冷静にいきたいところです。

すぐできる“安全×効果”チェックリスト(保存版)

- AI利用ポリシーのたたき台を1枚作る(社外公開用途は人手審査必須と明記します)。

- データ来歴(ライセンス)台帳を作る(取得元、許諾範囲、停止・削除義務、連絡窓口)。

- ベンダー質問票を送る(学習データの由来、第三者監査、削除対応、インデムニティ有無)。

- RAG構成を優先する(自社文書+検索連携で回答、恒久学習は後回し)。

- 高リスク領域を指定する(歌詞・漫画・写真集などは生成→公開を原則禁止)。

- 公開前レビューをワークフロー化(著作権・商標・肖像の最低1名チェック)。

- ログと版管理(プロンプト・出力・公開先を追跡し、差し替えを容易にします)。

- 小さく導入して拡大(議事要約、社内FAQ、コード補助など低リスク領域から)。

- プロンプト定型と“禁則語”を整備(NGワードや出典明示のルールを共有します)。

- 月次ふりかえり(事故未然事例・良い活用例を“安全ニュースレター”で共有します)。

最後に(まとめ)

ニュースを見て「やっぱりAIは危ない」と感じるのは自然ですが、危険なのは“AIそのもの”ではなく“調達と運用の設計ミス”だと考えると、打ち手が見えてきます。

由来が明確なデータを使い、参照型(RAG)で始めて、公開前の人手チェックを欠かさない。たったこれだけで、リスクは大きく下がります。

今回の和解報道は、極端な二択ではなく設計の勝負だと教えてくれました。焦らず、でも止まらず。“止まらないスピード”を一緒につくっていきましょう。

参考リンク

- Anthropic、作家側と15億ドルで和解へ(AP)

https://apnews.com/article/anthropic-copyright-authors-settlement-training-f294266bc79a16ec90d2ddccdf435164 - ワシントン・ポスト:史上最大級の著作権和解($1.5B)

https://www.washingtonpost.com/technology/2025/09/05/anthropic-book-authors-copyright-settlement/ - ロイター:和解条件と今後の訴訟影響

https://www.reuters.com/sustainability/boards-policy-regulation/anthropic-tells-us-judge-it-will-pay-15-billion-settle-author-class-action-2025-09-05/

少し深掘り(英語の詳報・解説)

- WIRED:条件の内訳と“1点$3,000”の意味

https://www.wired.com/story/anthropic-settlement-lawsuit-copyright/ - The Guardian:判事承認の見込み・波及効果

https://www.theguardian.com/technology/2025/sep/05/anthropic-settlement-ai-book-lawsuit - Axios:数字の“見取り図”

https://www.axios.com/2025/09/05/anthropic-ai-copyright-settlement

国内メディア

- 朝日新聞:AI企業が学習に海賊版利用、著作権者側に2200億円支払いで和解

https://www.asahi.com/articles/AST957RB1T95UHBI004M.html - 毎日新聞:米新興AI企業、著作権訴訟で2200億円支払いへ 作家らと和解

https://mainichi.jp/articles/20250906/k00/00m/020/049000c - ITmedia:Anthropic著作権侵害訴訟、和解へ──史上最高額の著作権回収に

https://www.itmedia.co.jp/news/articles/2509/06/news037.html - 共同通信(熊本日日):AI開発で著作権侵害訴訟、2千億円支払いへ

https://kumanichi.com/articles/1884257